来源:小编 更新:2024-11-17 12:28:28

用手机看

在机器学习领域,Ensemble(集成)技巧是一种通过结合多个模型来提高预测准确性和泛化能力的方法。本文将深入探讨Ensemble技巧的原理、常用方法以及在实际应用中的优势。

Ensemble技巧的核心思想是将多个弱学习器(Weak Learners)组合成一个强学习器(Strong Learner)。弱学习器通常指的是那些性能一般但相对简单的模型,如决策树、随机森林等。通过集成多个弱学习器,可以有效地减少过拟合,提高模型的泛化能力。

Ensemble技巧的原理主要基于以下几个关键点:

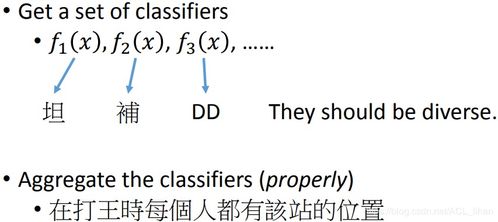

多样性:集成多个具有不同结构和参数的模型,可以增加模型的多样性,从而提高模型的泛化能力。

互补性:不同模型在处理数据时可能存在互补性,即一个模型在某个方面的不足可以被另一个模型所弥补。

降低过拟合:集成多个模型可以降低单个模型对训练数据的依赖,从而减少过拟合现象。

目前,常用的Ensemble技巧主要包括以下几种:

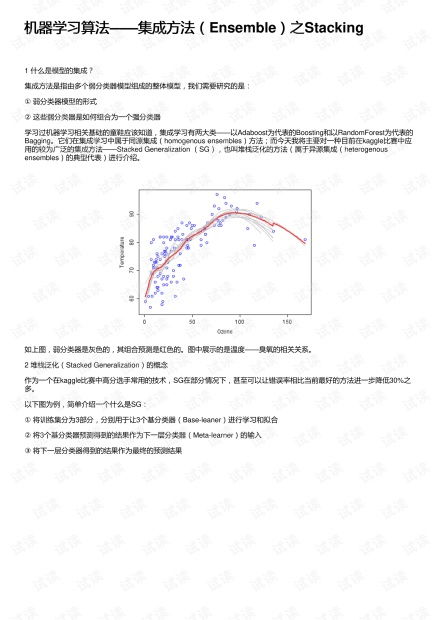

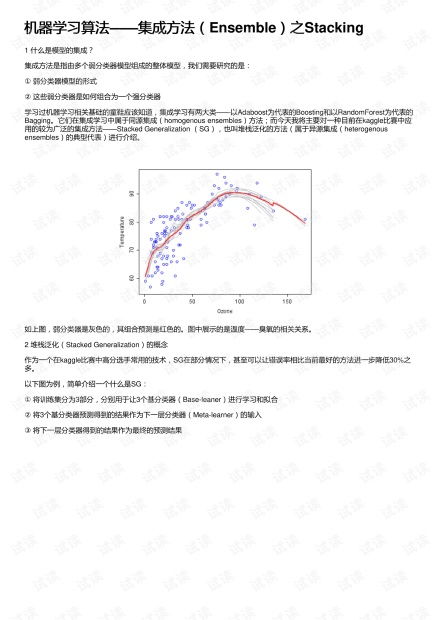

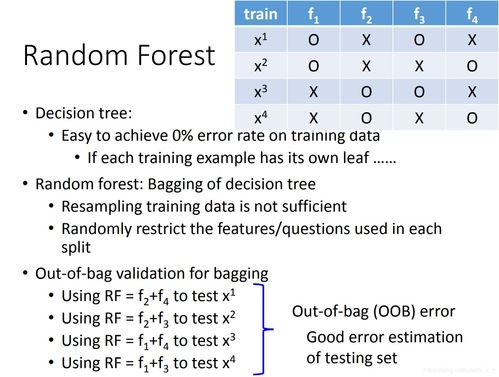

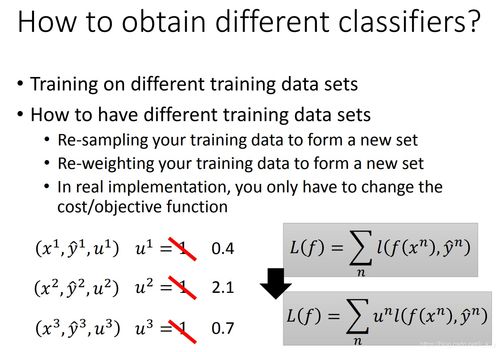

Bagging:通过bootstrap抽样方法从原始数据集中抽取多个子集,分别训练多个模型,然后对它们的预测结果进行平均或投票。

Boosting:通过迭代地训练多个模型,每个模型都针对前一个模型的错误进行优化,从而提高模型的性能。

Stacking:将多个模型作为基学习器,再训练一个模型来整合这些基学习器的预测结果。

Ensemble技巧在实际应用中具有以下优势:

提高预测准确率:集成多个模型可以有效地提高预测准确率,尤其是在处理复杂问题时。

增强泛化能力:Ensemble技巧可以降低过拟合现象,提高模型的泛化能力。

提高鲁棒性:集成多个模型可以降低单个模型对异常值的敏感性,提高模型的鲁棒性。

Ensemble技巧是一种有效的提升机器学习模型性能的方法。通过集成多个弱学习器,可以有效地降低过拟合,提高模型的泛化能力和鲁棒性。在实际应用中,选择合适的Ensemble技巧对于提高模型性能具有重要意义。